پژوهشگران هوش مصنوعی در دفاع و حمله به رقابت میپردازند

مایکروسافت به همراه سه شریک دیگر (CUJO AI، VMRay و MRG Effitas) رقابت گریز از امنیت یادگیری ماشین را برگزار میکنند.

پژوهشگران هوش مصنوعی در دفاع و حمله به رقابت میپردازندمایکروسافت به همراه سه شریک دیگر (CUJO AI، VMRay و MRG Effitas) رقابت گریز از امنیت یادگیری ماشین را برگزار میکنند. این مسابقه به محققان کمک میکند تا قابلیتهای دفاعی و تهاجمی خود را در دنیای واقعی بهبود دهند |

|

|

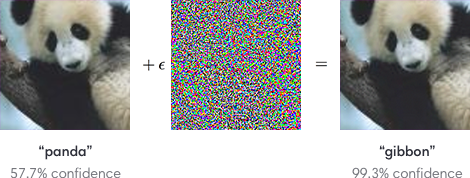

در دنیایی که مهاجمین سایبری دائماً تکنیکهای خود را تغییر میدهند تا از تشخیص بدافزار فرار کنند، یادگیری ماشین در حوزه امنیت ارزش بیشتری پیدا میکند. همانطور که یادگیری ماشین پیشرفت کرده و مدلهای پیچیده یادگیری ماشین برای امنیت توسعه دادهشدهاند، افراد متخاصم نیز مشغول توسعه بدافزارهایی بودهاند که بتوانند از این مدلها بگریزند. رقابت گریز از امنیت یادگیری ماشین بهمنظور مقابله با این چالش ترتیب دادهشده است. این رقابت از دو بخش حمله و دفاع تشکیلشده است. مسابقه دفاع از 15 ژوئن تا 23 جولای (26 خرداد تا 2 مرداد) و مسابقه دفاع از 6 آگوست تا 18 سپتامبر (16 مرداد تا 28 شهریور) برگزار میشود. حمله تخاصمی چیست؟ فرض کنید یک الگوریتم یادگیری ماشین ایجاد کردهایم که نوع تصاویر را تشخیص میدهد. شکل زیر مثال معروفی را نشان میدهد که برای توضیح حملات تخاصمی مورداستفاده قرار میگیرد. در این شکل میبینید که با اضافه کردن مقدار ناچیزی نویز به تصویر پاندا، الگوریتم گمراه میشود و تصویر را با اطمینان 99.3 درصد به عنوان گیبون (نوعی میمون) تشخیص میدهد. تفاوت بین دو تصویر به قدری کوچک است که حتی چشم انسان آن را تشخیص نمیدهد. |

|

|

حال در دنیای امنیت، مهاجمان سعی میکنند بدافزار خود را طوری تغییر دهند که عملکرد آن حفظ شود، اما بتواند الگوریتمهای تشخیص را فریب دهد. بنابراین متخصصان امنیت باید الگوریتمهای تشخیص را طوری توسعه دهند که نسبت به حملات تخاصمی مقاوم باشند. هرچند روی حملات تخاصمی روی مدلهای بینایی ماشین مطالعات زیادی انجام گرفته است، حوزه بدافزار واقعیتر و بسیار پیچیدهتر است. یکی از اثرات این مسابقه این است که محققان یادگیری ماشین که در گریز از سیستمهای تشخیص تصاویر تجربه دارند با مدلهای تهدید رایج در دنیای امنیت اطلاعات آشنا شوند. از سویی متخصصان امنیت دید بهتری نسبت به امن سازی سیستمهای هوش مصنوعی پیدا میکنند. درباره مسابقه سال گذشته مسابقه مشابهی تحت عنوان رقابت گریز بدافزار توسط Endgame، VMRay و MRG Effitas ترتیب دادهشده بود. در آن مسابقه مدلهای تشخیص بدافزار در اختیار شرکتکنندگان قرار داشت و آنها باید طوری بدافزار را طراحی میکردند که بتواند مدلها را دور بزند. اما مسابقه امسال از نوع «جعبه سیاه» است، یعنی شرکتکنندگان به الگوریتمهای تشخیص بدافزار دسترسی ندارند. علاوه بر این، مسابقه جدید در دو بخش دفاع و حمله برگزار میشود. در بخش دفاع شرکتکنندگان باید یک تصویر داکر ثبت کنند که یک فایل باینری اجرایی (PE) را دریافت میکند و خروجی صفر (سالم) یا یک (مخرب) برمیگرداند. نرخ مثبت کاذب (تشخیص فایل سالم به عنوان بدافزار) آن باید حداکثر یک درصد و منفی کاذب (تشخیص ندادن بدافزار) حداکثر ده درصد باشد. در بخش حمله، شرکتکنندگان از طریق یک API به مدلهای تشخیص بدافزار دسترسی خواهند داشت. شرکتکنندگان میتوانند فایل خود را به مدل تشخیص بفرستند و خروجی مدل را دریافت کنند و بر اساس این خروجیها نحوه فریب دادن مدل را کشف کنند. البته تعداد پرسشهایی که به طور آزمایشی به مدل فرستاده میشود نیز در رتبهبندی تأثیر دارد و هر چه کمتر باشد بهتر است. مدلهای تشخیص ثبت شده در بخش دفاع نیز در این مرحله مورداستفاده قرار میگیرند و در واقع الگوریتمهای ثبت شده در بخش دفاع و حمله پنجه در پنجه یکدیگر میاندازند. جایزه بزرگ هر کدام از دو مسابقه 2500 دلار و جایزه اول آن 500 دلار است که در قالب اعتبار Microsoft Azure به برندهها اعطا میشود.

منبع: مایکروسافت |